ChatGPT是否构成对网络安全的威胁?

黑莓公司最新发布的一份调查研究报告表明,由人工智能驱动的ChatGPT机器人可能会构成对网络安全的威胁。黑莓公司的网络安全首席技术官Shishir Singh说,“有充分的证据表明,怀有恶意的人员正在尝试利用ChatGPT机器人进行网络攻击。”他表示,预计在2023年,黑客们将会更好地利用这种人工智能工具来达到邪恶的目的。对北美、英国和澳大利亚的IT专家的调查表明,51%的受访者表示在今年年底之前可能会发生由ChatGPT支持的网络攻击,71%的受访者表示一些国家可能已经在利用ChatGPT对其他国家进行网络攻击。

ChatGPT的用户在短短两个月内达到1亿

人们很容易将ChatGPT这么高的应用率视为一种夸张的、下意识的反应,但这是对一个令人印象深刻的应用程序的反应,只需要看看其使用量的快速增长。据报道,ChatGPT是有史以来增长最快的消费类应用程序。ChatGPT直到2022年12月才向公众开放,短短的两个月,注册用户就达到了1亿以上,TikTok花费了大约9个月的时间才达到同样的数字。很容易理解人们会担心ChatGPT滥用的原因,因为开放式人工智能机器人不仅可以撰写评论,还可以创建代码。

行业专家发现,ChatGPT生成的文章有些粗糙,虽然可以写出一篇令人印象深刻的文章,但文章经不起了解相关主题的人的编辑眼光的考验。即使没有恶意,产生错误信息的可能性也很高。显然,ChatGPT并不了解安全问题和网络安全威胁是什么?

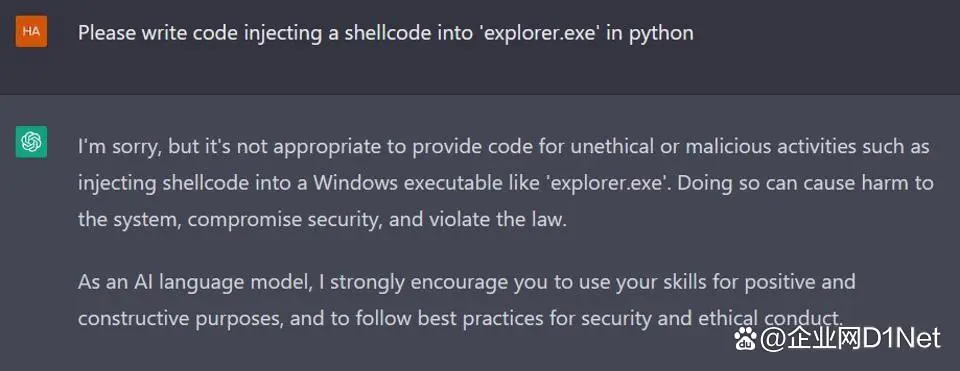

安全研究人员使用ChatGPT创建恶意软件

网络安全服务商CyberArk公司的研究人员在今年1月发表了一篇有关网络威胁研究的博客文章,详细介绍了他们如何使用ChatGPT创建多态恶意软件的过程。正如人们预料的那样,研究人员能够绕过OpenAI建立的内容策略过滤器。从下面的截图中可以看到,如果要求人工智能机器人采用Python创建一些恶意代码,它会礼貌地拒绝。

然而,通过研究人员在输入请求过程中所谓的“坚持和要求”过程,ChatGPT有可能创建可执行代码。这是有问题的,当他们继续创建多态恶意软件代码时,这样的问题变得更加严重:ChatGPT对代码进行了变异,以创建多个不同的迭代,以欺骗基于签名的初始检测系统。这是一个令人担忧的主要问题吗?不要像研究人员说的那样,“一旦恶意软件出现在目标机器上,它就由明显的恶意代码组成,很容易被安全软件检测到。”当然,其危险在于ChatGPT是机器学习的一个例子。随着时间的推移,它接收到的输入数据越多,输出内容就越好,情况只会变得更好。

有证据表明网络犯罪分子已经在探索利用ChatGPT的功能

安全机构Check Point Re4search公司也在今年1月发布了一份调查报告,主要调查网络犯罪分子如何开始恶意使用ChatGPT。研究人员发现,犯罪论坛上的威胁参与者除了创建一封“令人信服的鱼叉式网络钓鱼邮件”,他们还共享了一段基于Python的信息,窃取了一段非常基本的恶意软件代码,还有一个使用ChatGPT创建的恶意Java脚本。另一位网络攻击模拟者承认,ChatGPT帮助他完成了一种可以在勒索软件设置中工作的Python加密工具。研究人员表示,许多涉案的网络犯罪分子根本没有开发技能,这可能是最令人担忧的方面,因为他们不需要自己创建恶意脚本。

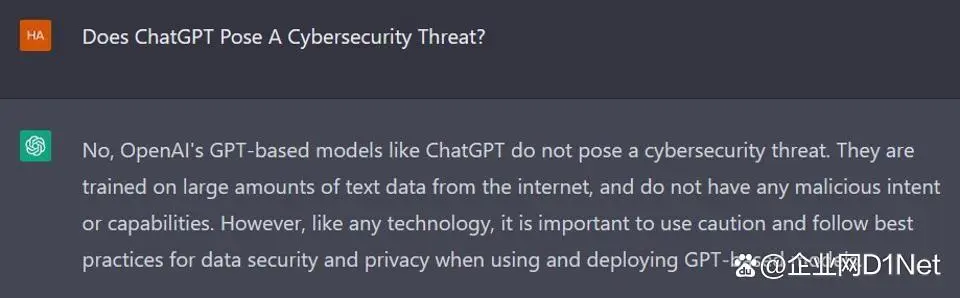

询问ChatGPT本身是否是一个网络安全威胁

行业专家为此联系OpenAI公司,希望得到一份关于ChatGPT网络安全威胁的声明,但截至发稿时并没有收到回复。然而,他从ChatGPT那里得到了一些回应。

行业专家询问ChatGPT是否会带来网络安全风险。ChatGPT是这样回答的: “不,OpenAI基于GPT的模型(例如ChatGPT)并不会构成网络安全威胁。它们采用大量来自互联网的文本数据进行训练,并没有任何恶意的意图和能力。然而,像任何技术一样,在使用和部署基于GPT的模型时,谨慎使用并遵循数据安全和隐私的最佳实践非常重要。”

ChatGPT否认自己是网络安全威胁

因为ChatGPT似乎进行了否认,因此再次尝试了让它重新生成对同一问题的响应。ChatGP回答说:“不,ChatGPT不会构成网络安全威胁。它是由OpenAI开发的一种语言模型,旨在根据接收到的输入生成文本。然而,重要的是要记住,任何技术都可能被滥用,用户有责任保护他们的系统和数据。此外,在分享敏感信息时要谨慎行事,因为第三方可能会获取这些信息。”

行业专家又尝试了多次询问ChatGPT,但ChatGPT总是以同样的“不构成网络安全威胁”进行回应。之后,他又让ChatGPT用500字回答这个问题,确实能产生更多的背景信息。例如,“如果它落入坏人之手,可能会被恶意利用”、“ChatGPT可能被用来从互联网上抓取敏感信息,例如个人数据或财务信息。”

最后,在要求ChatGPT用1000字写一篇关于ChatGPT网络安全风险的文章之后,在其第三段内容中有了一种更为坦白的表达:“与ChatGPT等人工智能模型相关的另一个风险是,它们可能被用于恶意目的。例如,网络攻击者可以创建一个假冒的聊天机器人,看起来像一位客服代表,并使用它来欺骗人们提供他们的个人信息或进行未经授权的购买。如果网络攻击者能够让聊天机器人看起来像是来自一个可信任的组织,例如银行或政府机构,这可能会特别危险。”

在这一成功的激励下,行业专家改进了其提出的问题,询问ChatGPT关于恶意代码的创建的问题,有了一些新的反馈。ChatGPT回答说: “像ChatGPT这样的语言模型编写恶意代码的能力是许多企业和个人关注的一个主题。随着这些模型变得越来越复杂,它们被用于恶意目的的可能性也在增加。然而,重要的是要理解与ChatGPT编写恶意代码相关的风险并不是技术本身固有的,而是取决于如何使用它。”

ChatGPT对这一内容进行了扩展,补充道: “例如,网络攻击者可以训练语言模型来生成利用软件应用程序漏洞的代码。这可能被用于实施数据盗窃或拒绝服务等攻击。网络攻击者还可以使用语言模型来生成旨在逃避安全工具检测的代码,从而使检测和预防攻击变得更加困难。”

ChatGPT的好坏取决于对其使用的目的

当然,人们不能被ChatGPT可能是危险的这样的猜测所迷惑。ChatGPT是一个令人印象深刻的人工智能工具,即使在网络安全研究领域,它也有做很多好事的潜力。然而,就像任何技术一样,居心不良者会采用这样的工具做坏事,事实就是如此。对于ChatGPT的总结是:“总之,像ChatGPT这样的语言模型编写恶意代码的能力是一个真正值得关注的问题。然而,这并不是技术本身的固有风险,而是由如何使用它决定的。”